人工智能及其治理的国际规则塑造:人道考量

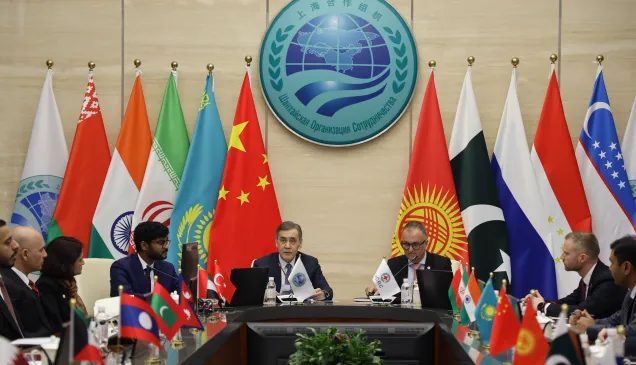

11月9日,红十字国际委员会主席中国事务个人特使、东亚地区代表处主任史德林应邀出席2025世界互联网大会乌镇峰会,并在网络空间国际规则论坛上发言。

感谢主持人的热情介绍。能够受邀参加本论坛我深感荣幸,首先请允许我向论坛主办方致以诚挚的谢意。

在开始发言内容之前,请允许我简要介绍我所任职的组织——红十字国际委员会。红十字国际委员会是一个公正、中立和独立的组织,其特有的人道使命是保护武装冲突和其他暴力局势受难者的生命与尊严,并向他们提供援助。160多年来,红十字国际委员会在无数战争和武装冲突中开展行动,为亟需帮助之人提供援助。

红十字国际委员会在战争和冲突中开展行动的独特职责,使我们得以亲眼目睹了这些局势对平民居民的影响,这些来自一线的观察深刻影响了我们对国际法发展的贡献,也构成了我今天发言的基础。

今天,我将重点阐述在制定人工智能及其治理的国际规则时必须关注的若干关键人道考量。

首先,我想谈谈自主武器系统中人工智能的使用问题。红十字国际委员会认为,自主武器系统是在没有人类干预的情况下选择目标并对其使用武力的武器系统。这就意味着,自主武器系统在最初由人启动或发射后,能够自行选择目标并发动攻击。随着人工智能技术的发展,人工智能完全可以在自主武器系统中用于执行目标识别和选择。换言之,如今存在将事关生死的决策交由机器完成,而几乎或完全无需人类干预的现实能力。

因此,自主武器系统无疑会带来人道、法律和伦理方面的严重关切。由机器作出的杀戮决定能否遵守国际人道法?如果机器出错,谁该为违法行为承担责任并接受问责?国际人道法要求军事决策中必须有人类的判断和决策,因为人类生命神圣不可侵犯,绝不能由机器作出生杀予夺的裁断。冲突带来的人道代价,往往表现为平民死亡和民用物体被毁,这些都是真切的现实后果,绝不应该被简化为冰冷的统计数字、代码和算法。

为了应对这些关切,红十字国际委员会敦促各国就自主武器系统制定国际规则。具体而言,国际规则应规定禁止使用不可预测的自主武器系统,以及禁止使用自主武器系统攻击人类。截至目前,有关自主武器系统的讨论仍在持续进行,例如联合国相关进程中的讨论。去年,红十字国际委员会和联合国秘书长联合呼吁在2026年前就自主武器系统开展谈判并达成具有法律约束力的国际规则。

其次,我想谈谈人工智能在军事领域更广泛的使用,例如在军事规划和决策等方面。诚然,当代武装冲突中已经出现了用于军事用途的人工智能决策支持系统,这些计算机工具能够整合多种来源的数据(例如卫星图像、传感器数据、社交媒体信息流),并基于这些数据进行分析、提出建议或作出预判。例如,人工智能决策支持系统可以分析无人机拍摄素材,并使用图像分类技术在武装冲突中识别并对潜在攻击目标进行分类。人工智能决策支持系统能够将冲突进程由人类速度加速为机器速度,而这会带来重大风险。

另一个令人担忧的问题在于将人工智能用于指导核武器或其他大规模毁灭性武器的使用决策,这可能会加剧核武器使用的风险,并造成灾难性的后果。

从人道角度出发,使用人工智能决策支持系统可能会在武装冲突中为平民和其他受保护人员带来额外的风险。这背后有多种原因,既有人工智能固有的“黑箱问题”,还有人工智能并不适合执行战场上的所有任务,以及人工智能偏见等问题。这并不是说人工智能无法为人类决策提供支持,但人工智能绝不能取代人类决策,尤其在军事领域更是如此。强调人类控制和人类判断,理应成为制定人工智能国际规则的首要原则。

刚才我谈的都是人工智能带来的风险,但人工智能同时也为人道领域带来了诸多机遇。正如中国《人工智能全球治理行动计划》中所提到的,“人工智能带来前所未有发展机遇,也带来前所未遇风险挑战”。红十字国际委员会的工作也印证了这一点,我们使用人工智能为人道行动提供支持,并取得了积极成果。

我相信,制定国际规则定将发挥关键作用,推动人工智能的使用遵守国际法并符合伦理和人道价值。人工智能与世间任何工具一样,如何使用取决于使用者,而使用者的行为则由法律法规指导。

目前,从联合国进程到地区及双边论坛,许多论坛正在就人工智能监管开展讨论,未来可期。但不可否认的是,当前讨论和磋商的进度远不及该领域技术创新的速度。另外,还必须注意,相关讨论不能只关注人工智能的和平利用,却忽视在军事领域使用人工智能可能会对平民带来破坏性影响这一现实情况。我们必须共同将人道精神置于人工智能讨论的核心位置。人工智能及其治理的国际规则制定必须始终坚持以人为本,确保无论如何都充分纳入人道考量。

谢谢大家。